Dynalips, une nouvelle start-up lorraine spécialisée dans la synchronisation labiale

Pionnière en modélisation de la parole et en synthèse vocale audiovisuelle, la start-up Dynalips est officiellement lancée. Issue des travaux de recherche du Loria (CNRS, Université de Lorraine, Inria, CentraleSupélec), ayant fait l'objet d'un programme de maturation de la Société d'Accélération du Transfert de Technologie - SATT Sayens et accompagnée par l'Incubateur Lorrain, elle propose aux animateurs et aux développeurs de jeux vidéo une solution de synchronisation labiale (lipsync) innovante pour synchroniser précisément, automatiquement et rapidement les mouvements des lèvres d'un personnage 3D ou 2D avec la parole.

Pionnière en modélisation de la parole et en synthèse vocale audiovisuelle, la start-up Dynalips est officiellement lancée. Issue des travaux de recherche du Loria (CNRS, Université de Lorraine, Inria, CentraleSupélec), ayant fait l'objet d'un programme de maturation de la Société d'Accélération du Transfert de Technologie - SATT Sayens et accompagnée par l'Incubateur Lorrain, elle propose aux animateurs et aux développeurs de jeux vidéo une solution de synchronisation labiale (lipsync) innovante pour synchroniser précisément, automatiquement et rapidement les mouvements des lèvres d'un personnage 3D ou 2D avec la parole.

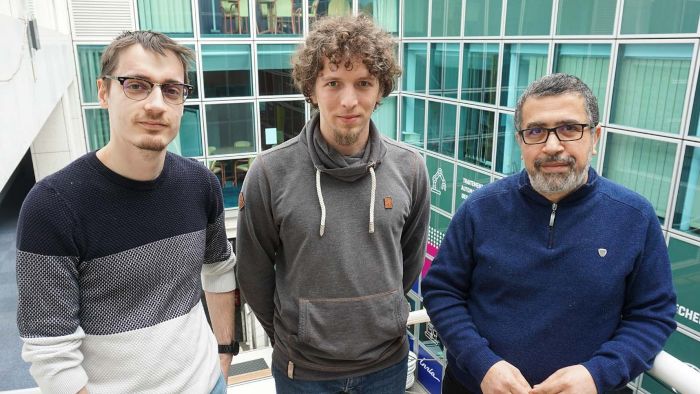

Photo (de droite à gauche) : Slim Ouni, dirigeant de la start-up ; Théo Biasutto-Lervat, ingénieur Inria, qui a travaillé sur ce sujet pendant sa thèse ; Louis Abel, doctorant à l'Université de Lorraine.

Le secteur de l'animation est en constante évolution, avec des décors, des effets spéciaux et des personnages de plus en plus réalistes. Mais qu'en est-il de la parole des personnages ? Un des défis à relever pour les animateurs professionnels est de modéliser les mouvements de la bouche et les expressions faciales. Actuellement, l'animation labiale est loin d'être parfaite, car elle ne prend pas en compte la coarticulation, un phénomène où la prononciation d'un son est influencée par les sons qui l'entourent. La start-up Dynalips offre une solution de synchronisation labiale automatique basée sur les derniers résultats de la recherche dans le domaine. Elle prend notamment en compte la coarticulation, essentielle pour permettre une parole plus fluide, naturelle, et surtout intelligible.

Dynalips, résultat de dix ans de recherche et développement en modélisation de la parole

La technologie DeepLipSync développée par la start-up Dynalips s'appuie sur l'expertise d'une équipe de scientifiques (cf. photo et légende ci-contre). Slim Ouni, professeur à l'Université de Lorraine et responsable de l'équipe, démarre les travaux sur le lipsync en 2015. Il remarque alors qu'aucun outil satisfaisant pour synchroniser automatiquement les lèvres des personnages avec leur parole n'existe. L'équipe se développe, les chercheurs apportent leur expertise en apprentissage profond (deep-learning) et en traitement de la parole.

Avec le dispositif des passerelles public-privé prévu par la loi PACTE, je peux me consacrer, pendant un an, au lancement de la start-up que je dirige, via une mise à disposition qui permet de répartir mon temps entre la startup, et l'enseignement et la recherche au sein de l'Université de Lorraine"

précise Slim Ouni, dirigeant de la start-up.

Une technologie puissante pour révolutionner le monde de l'animation et des jeux vidéo

Dynalips ouvre aujourd'hui sa technologie aux professionnels, notamment aux studios d'animation et aux studios de création de jeux vidéo. Actuellement, l'animation de la bouche d'avatars est réalisée manuellement, un travail particulièrement chronophage pour les professionnels.

Notre outil leur permet d'animer les lèvres des personnages en synchronisation avec la parole prononcée en quelques secondes, contre une journée de travail en studio lorsque le processus est fait à la main.",

souligne Slim Ouni.

"Dynalips offre ainsi un temps de production plus court et donne la possibilité aux animateurs de se concentrer sur des tâches artistiques comme les expressions faciales et les caractéristiques uniques du personnage."

Le fonctionnement est simple : l'utilisateur fournit au système l'enregistrement audio et reçoit en retour l'animation faciale du personnage.

En plus des studios d'animation, Dynalips couvre un large spectre d'applications, comme les systèmes d'apprentissage des langues, les assistants virtuels ou les applications d'assistance aux malentendants, dans lesquelles la précision des mouvements des lèvres est primordiale pour que le message soit intelligible.

De brillants résultats

La start-up a d'ores et déjà obtenu de brillants résultats. Elle est lauréate de la dixième édition du Prix Pépite initié par le Ministère de l'Enseignement Supérieur, de la Recherche et de l'Innovation et s'est vue décerner une bourse Epic MegaGrants par le studio international de jeux vidéo Epic Games, qui lui a permis d'apporter la preuve de concept de sa technologie.

Nous avons appliqué notre technologie à l'animation des MetaHumans, des modèles humains en 3D hyperréalistes, et ainsi validé la précision et le réalisme de la solution."

Le prochain défi à venir ? Développer une version multilingue et temps-réel de la solution pour l'ouvrir au marché mondial.